В четверг компания Apple заявила, что она внедряет новые функции для защиты детей в iOS, iPadOS, watchOS и macOS в рамках своих усилий по ограничению распространения материалов о сексуальном насилии над детьми (CSAM) в США.

В связи с этим производитель iPhone заявил, что намерен начать сканирование на стороне клиента изображений, передаваемых через каждое устройство Apple, на предмет содержания известных материалов, связанных с насилием над детьми, в момент их загрузки в iCloud Photos, а также использовать машинное обучение на устройстве для проверки всех изображений iMessage, отправленных или полученных аккаунтами лиц в возрасте до 13 лет, чтобы предупредить родителей об откровенных фотографиях, передаваемых через платформу обмена сообщениями.

Кроме того, Apple также планирует обновить Siri и Search, чтобы при попытке пользователей выполнить поиск по темам, связанным с CSAM, предупреждать, что «интерес к этой теме вреден и может повлечь за собой проблемы».

«Мессенджер использует машинное обучение на устройстве для анализа вложеных изображений и определения того, является ли фотография сексуально откровенной» - отметили в Apple. «Функция разработана таким образом, что Apple не получает доступ к сообщениям». Функция, названная «Безопасность общения», как утверждается, является настройкой, которую родители должны включить через функцию «Family Sharing».

Как выявляются материалы о сексуальном насилии над детьми?

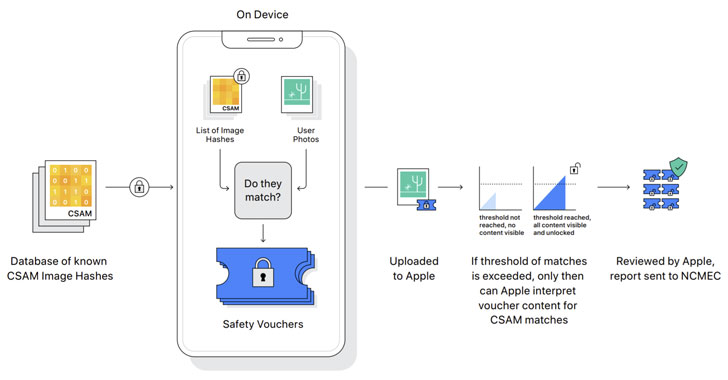

Обнаружение известных изображений CSAM включает в себя проведение сопоставления на устройстве с использованием базы данных хэшей известных изображений CSAM, предоставленных Национальным центром пропавших и эксплуатируемых детей (NCMEC) и другими организациями по защите детей, до того, как фотографии будут загружены в облако. «NeuralHash» - так называется система - работает на основе криптографической технологии, известной как пересечение частных множеств. Однако стоит отметить, что хотя сканирование происходит автоматически, функция работает только при включенном совместном использовании фотографий в iCloud.

Более того, ожидается, что Apple будет использовать другой криптографический принцип под названием «порог секретного обмена», который позволяет «интерпретировать» содержимое, если аккаунт iCloud Photos пересекает некий «порог» содержания известных изображений насилия над детьми, после чего содержимое аккаунта просматривается вручную чтобы подтвердить наличие совпадений и если это так - аккаунт пользователя будет отключен а о материалах будет сообщено в NCMEC и правоохранительным органам.

Исследователи выражают беспокойство по поводу конфиденциальности.

Инициатива борьбы со CSAM компании Apple побудила исследователей безопасности выразить опасения, что в ее ходе может начаться смещение приоритетов и подобная «аналитика» может быть расширена для обнаружения других видов контента, который может иметь политические последствия и последствия для безопасности, или даже применена для ложных обвинений невинных людей через отправку им безобидных, но вредоносных изображений, специально созданных для того, чтобы казаться совпадениями с детским порно.

Американский разоблачитель Эдвард Сноуден написал в Твиттере, что, несмотря на благие намерения проекта, то, что делает Apple, является «массовой слежкой», а профессор криптографии Университета Джонса Хопкинса и эксперт по безопасности Мэтью Грин заявил: «Проблема в том, что шифрование - это мощный инструмент, обеспечивающий конфиденциальность, и вы не можете обеспечить надежную конфиденциальность, одновременно следя за каждым отправляемым изображением».

Apple уже проверяет файлы iCloud и изображения, отправляемые по электронной почте, на предмет известных случаев насилия над детьми, как и такие технологические гиганты, как Google, Twitter, Microsoft, Facebook и Dropbox, которые используют аналогичные методы хэширования изображений для поиска и отметки потенциальных материалов о насилии, но очередная попытка компании на постоянной основе нарушать конфиденциальность данных собственных пользователей может возобновить дебаты об ослаблении шифрования, обостряя давнее противостояние по вопросам конфиденциальности и полицейского контроля в цифровую эпоху.

В ходе расследования, проведенного в 2019 году газетой New York Times, выяснилось, что в 2018 году было зафиксировано рекордное количество сообщений о 45 миллионах фотографий и видеозаписей сексуального насилия над детьми в Интернете, из которых почти две трети пришлось на Facebook Messenger, а на Facebook в целом пришлось 90% сообщений.

Грядущие изменения также знаменуют собой определенный поворот для компании, которая, наряду с принадлежащим Facebook WhatsApp, постоянно сопротивлялась попыткам намеренно ослабить шифрование и сделать бэкдоры в своих системах. Так, в прошлом году агентство Reuters сообщило, что компания отказалась от планов шифрования полных резервных копий пользователей в iCloud в 2018 году после того, как Федеральное бюро расследований США выразило опасения, что это может помешать проведению уголовных расследований.

«Эксплуатация детей - это серьезная проблема, и Apple - не первая технологическая компания, которая изменила свою позицию по защите приватности в попытке бороться с ней. Но этот выбор будет стоить высокой цены для конфиденциальности пользователей в целом» - говорится в заявлении Electronic Frontier Foundation (EFF), отмечая, что шаг Apple может разрушить защиту шифрования и открыть дверь для более серьезных злоупотреблений.

«Чтобы злоупотребить функционалом, который создает Apple, достаточно расширить параметры машинного обучения и искать дополнительные типы контента, или изменить флаги конфигурации чтобы сканировать не только детские, но и любые другие учетные записи. Это скользкая дорожка - появится полностью построенная система, которая только и ждет внешнего давления, чтобы внести эти малейшие изменения и начать следить за всеми» - добавили в компании.

Функционал по борьбе с CSAM должен быть развернут в США в ближайшие месяцы в рамках iOS 15 и macOS Monterey, но пока неясно, будет ли он доступен на международном уровне, и если да - то когда. В декабре 2020 года Facebook был вынужден отключить некоторые из своих инструментов выявления насилия над детьми в Европе в ответ на недавние изменения в директиве Европейской комиссии по электронной конфиденциальности, которые фактически запрещают автоматизированные системы, сканирующие изображения без явного согласия пользователей.

Источник: https://thehackernews.com